UPDATE

29. September 2025

Mit der Power von Apple Intelligence eröffnet das Apples Foundation Models Framework neue App-Erlebnisse

Mit der Veröffentlichung von iOS 26, iPadOS 26 und macOS 26 in diesem Monat können Entwickler:innen auf der ganzen Welt noch intelligentere Erlebnisse in ihre Apps integrieren, indem sie direkt auf dem Gerät auf das große Sprachmodell zugreifen, auf dem Apple Intelligence basiert.1 Das Foundation Models Framework ermöglicht es, neue intelligente Features zu entwickeln, die die Privatsphäre der Nutzer:innen schützen, offline verfügbar sind und gleichzeitig eine kostenlose KI Inferenz nutzen. Egal ob es darum geht personalisierte Quizfragen zur Unterstützung von Schüler:innen und Studierenden bei der Prüfungsvorbereitung zu erstellen, oder aufschlussreiche Zusammenfassungen von Trainingsdaten zu liefern – Entwickler:innen haben das Potenzial des Frameworks erkannt und genutzt, um ihre Apps zu überarbeiten und Nutzer:innen auf innovative und ansprechende Weise zu unterstützen.

„Wir freuen uns, dass Entwickler:innen auf der ganzen Welt bereits intelligente Features mit Datenschutz in ihre Apps integrieren. Die In-App Erlebnisse, die sie damit schaffen, sind vielseitig und kreativ und zeigen, welches enorme Potenzial das Foundation Models Framework eröffnet“, sagt Susan Prescott, Vice President of Worldwide Developer Relations bei Apple. „Von der Generierung von Prompts für kreative Tagebucheinträge in Stoic bis hin zu dialogorientierten Erklärungen wissenschaftlicher Begriffe in CellWalk – es ist beeindruckend zu sehen, wie leistungsstarke neue Funktionen schon heute die Apps bereichern, die Menschen täglich nutzen.“

Apps aus verschiedensten Kategorien – von Gesundheit und Fitness bis hin zu Bildung und Produktivität – setzen bereits auf das Foundation Models Framework. Im folgenden einige Beispiele von Apps, die auf das Framework zurückgegriffen haben, um neue intelligente Features bereitzustellen, die jetzt verfügbar sind.

Neue Gesundheits- und Fitness-Erlebnisse

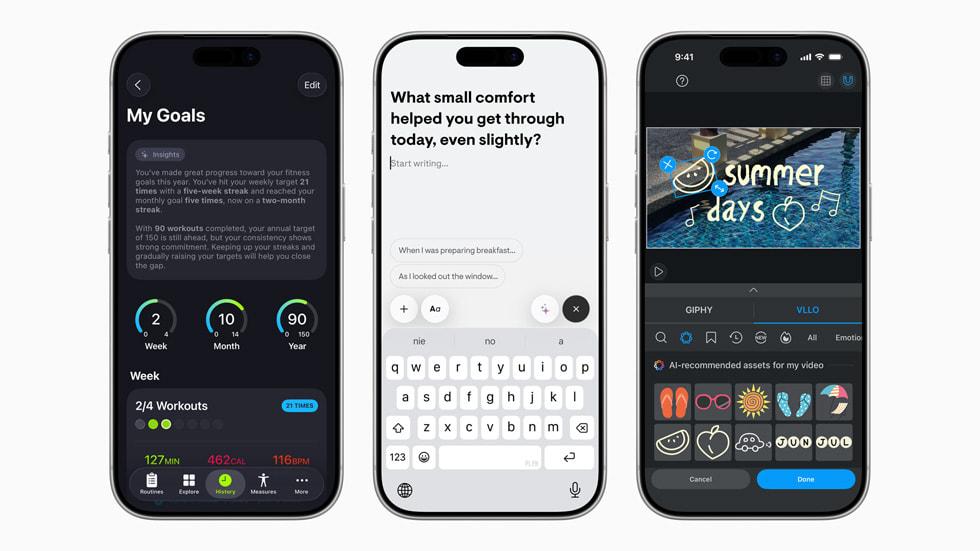

SmartGym bietet eine elegante und unkomplizierte Möglichkeit, Trainings zu planen und zu verfolgen. Dank Integration des Foundation Models Framework kann die App eine einfache Beschreibung des Workouts der Nutzer:innen in einen strukturierten Trainingsplan mit Sätzen, Wiederholungen, Pausen und gerätespezifischen Anpassungen verwandeln. Das Smart Trainer Feature der App lernt kontinuierlich aus den Trainingsdaten der Anwender:innen und gibt Empfehlungen, beispielsweise zur Anpassung von Wiederholungszahlen, Gewichten oder zur Erstellung neuer Trainingspläne. Ab sofort enthält jede Empfehlung eine klare Erklärung, damit Nutzer:innen die vorgeschlagenen Anpassungen besser nachvollziehen können.

SmartGym erstellt außerdem aufschlussreiche Zusammenfassungen der Trainingsdaten, darunter monatliche Fortschrittsübersichten, Routineaufschlüsselungen und individuelle Trainingsleistungen, die alle in einem einfachen, leicht verständlichen Format dargestellt werden. Darüber hinaus können Nutzer:innen Coaching-Nachrichten erhalten, die sich an ihren bevorzugten Kommunikationsstil anpassen. Nach Abschluss eines Trainings können sie persönliche Notizen hinzufügen oder automatisch eine vollständige Notiz auf der Grundlage der Trainingsdaten erstellen. Jedes Mal, wenn die App geöffnet wird, wird man von SmartGym mit einer personalisierten, dynamischen Nachricht begrüßt, die in Echtzeit auf Grundlage der aktuellen Fitnessdaten generiert wird.

„Das Foundation Models Framework ermöglicht es uns, Features auf dem Gerät bereitzustellen, die früher undenkbar gewesen wären,“ sagt Matt Abras, CEO von SmartGym.

„Es ist einfach zu implementieren und zugleich unglaublich leistungsstark.“

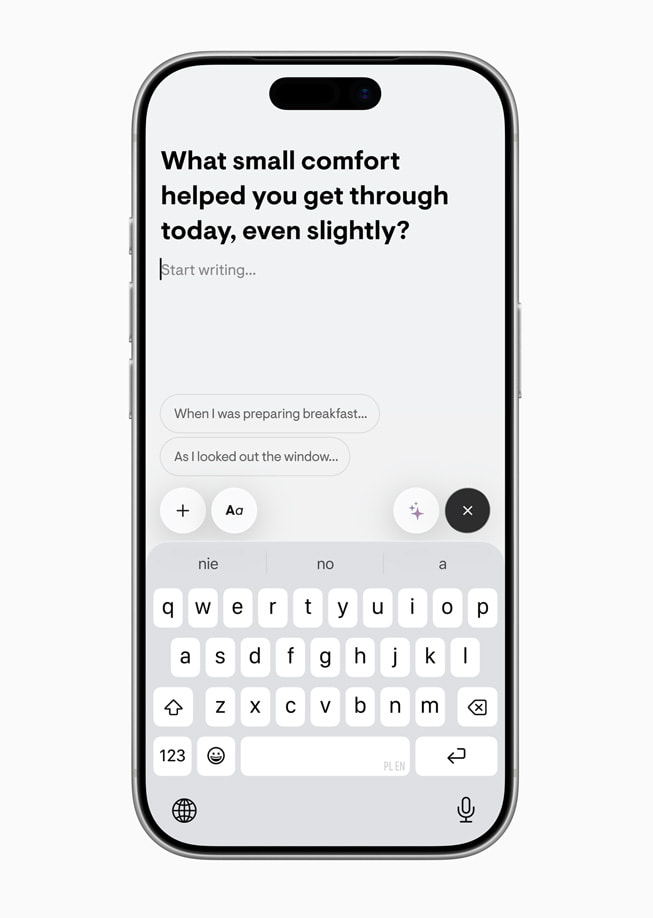

Stoic ist eine Tagebuch-App, die Nutzer:innen dabei unterstützt, ihre Emotionen besser zu verstehen und Erkenntnisse darüber zu gewinnen, wie sie glücklicher und produktiver werden und Hindernisse überwinden können. Mithilfe des Foundation Models Frameworks erhalten Nutzer:innen hochgradig personalisierte Prompts für das Tagebuchschreiben, die auf Basis ihrer letzten Einträge generiert werden. Wenn beispielsweise schlechte Stimmung oder unzureichender Schlaf protokolliert wird, erhalten Nutzer:innen eine einfühlsame, ermutigende Nachricht. Stoic kann außerdem kontextbezogene App-Benachrichtigungen senden, etwa Erinnerungen an kürzlich geschriebene Einträge oder erfasste Stimmungen. Die Prompts werden dabei direkt auf dem Gerät generiert, sodass die persönlichen Einträge auch stets privat bleiben.

Darüber hinaus kann die App nun kontextbasierte Journaling-Prompts vorschlagen, die zum Nachdenken einladen, ebenso wie individuell angepasste Anfangssätze, die den Einstieg in einen Eintrag erleichtern. Mit Unterstützung des Foundation Models Frameworks können Nutzer:innen zudem ihre vergangenen Einträge mit verbesserten Ansichten auf neue Weise reflektieren, darunter das Lesen von Zusammenfassungen ihrer Tagebucheinträge, das Organisieren verwandter Einträge und das Auffinden von Einträgen mithilfe der verbesserten natürlichen Sprachsuche der App.

„Mit dem Foundation Models Framework passen sich Prompts und Reflexionen nun an den Gemütszustand der Nutzer:innen an, sodass sich das Erlebnis persönlich anfühlt und sich von Tag zu Tag weiterentwickelt“, sagt Maciej Lobodzinski, Gründer von Stoic. „Was mich besonders beeindruckt hat, war, wie schnell wir diese Ideen umsetzen konnten. Features, die früher eine komplexe Backend-Infrastruktur erfordert haben, laufen jetzt nativ und mit minimalem Einrichtungsaufwand direkt auf dem Gerät. Dadurch konnte unser kleines Team in kürzester Zeit enormen Mehrwert schaffen und dabei sämtliche Nutzerdaten privat halten, da alle Einblicke und Prompts generiert werden, ohne dass jemals etwas ihr Gerät verlässt.“

Weitere Gesundheits- und Fitness-Apps haben das Foundation Models Framework genutzt, um völlig neue Erlebnisse in ihren Apps zu ermöglichen. SwingVision, eine App zur Verbesserung von Tennis- oder Pickleball-Fähigkeiten, generiert individuelle Empfehlungen, mit denen Nutzer:innen ihr Spiel verbessern können. Die App verwendet das Foundation Models Framework, um Videos aus dem Spiel von Anwender:innen zu analysieren, die zuvor mithilfe von Core ML Modellen erstellt worden sind, und liefert daraus präzises und umsetzbares Feedback. Mit 7 Minute Workout können Nutzer:innen dynamische Trainings mithilfe natürlicher Sprache erstellen, beispielsweise mit der Angabe, dass sie bestimmte Übungen vermeiden möchten, die eine Verletzung verschlimmern könnten, oder dass sie sich auf ein Event vorbereiten. Die App liefert außerdem motivierendes Feedback in einem freundlichen, natürlichen Ton. Die Tagebuch-App Gratitude erstellt detaillierte wöchentliche Zusammenfassungen von Herausforderungen, Erfolgen, Vorsätzen und vorgeschlagenen Affirmationen. Mithilfe des Foundation Models Frameworks wandelt die App außerdem Tagebucheinträge in persönliche, kontextbezogene Affirmationen um.

Train Fitness arbeitet ebenfalls mit dem Foundation Models Framework von Apple, um Nutzer:innen die nächste Übung zu empfehlen, wenn das erforderliche Equipment nicht verfügbar ist. Anwender:innen können ihre Workouts verfeinern, indem sie spezifische Angaben machen, beispielsweise zu bevorzugten Übungsarten oder muskulären Einschränkungen. Motivation liefert Anwender:innen positive Impulse und organisiert Inhalte, die Nutzer:innen als Favoriten markiert haben, in emotionale und thematische Kategorien, während Streaks Aufgaben in einer To-do-Liste intelligent vorschlägt und automatisch kategorisiert. Wakeout! generiert personalisierte Bewegungspausen mit detaillierten Begründungen für die vorgeschlagene Übung. Mithilfe generativer Strukturen wählt das Foundation Modell aus Tausenden von verfügbaren Videos aus und erstellt für jede:n Nutzer:in die passende Routine.

Neue Möglichkeiten für Bildungs-Apps

CellWalk, eine immersive Biologie-App, ermöglicht es Nutzer:innen, eine detaillierte 3D-Zelle bis auf molekulare Ebene zu erkunden, oder eine Tour durch die molekularen Prozesse des Lebens zu unternehmen. Studierende und Forschende können unbekannte Begriffe antippen, um eine Erklärung zu erhalten. Mithilfe des Foundation Models Frameworks generiert die App eine dialogorientierte Erläuterung des Begriffs, wobei Tool Calling verwendet wird, um die Antworten auf Grundlage der wissenschaftlichen Informationen der App zu untermauern. Durch Einrichtung eines Nutzerprofils passt CellWalk die Erklärungen an den Wissensstand des Lernenden an und speichert gleichzeitig den Verlauf, um den Lernprozess gezielt zu unterstützen.

„Das Modell auf dem Gerät liefert großartige Performance“, sagt Tim Davison, der Entwickler von CellWalk. Unsere Visuals sind schon immer interaktiv gewesen, aber durch das Foundation Models Framework wird der Text selbst lebendig. Die in unserer App versteckten wissenschaftlichen Daten werden zu einem dynamischen System, das sich an jeden Lernenden anpasst. Die zuverlässigen strukturierten Daten, die das Modell produziert, haben eine reibungslose Integration in unsere App möglich gemacht.“

Auch weitere Bildungs-Apps in unterschiedlichen Themenbereichen nutzen das Foundation Models Framework in ihren Apps. Der KI-Tutor von Grammo, der dabei hilft, englische Grammatik zu lernen, erklärt in Form eines Dialogs, warum eine Antwort, die Anwender:innen in einer Übung gewählt haben, falsch gewesen ist. Darüber hinaus verfügt Grammo jetzt über einen Abschnitt mit Übungen für Nutzer:innen, in dem spontan neue Fragen erstellt werden, wenn sie sich tiefer mit einem Thema befassen möchten. Lil Artist hat die Funktionen des Foundation Models Frameworks und der ImageCreator API kombiniert, um illustrierte Geschichten für Kinder individuell anzupassen. Kinder wählen Charaktere und Themen innerhalb der Benutzeroberfläche der App aus, anstatt ein offenes Textfeld zu verwenden, was das Erlebnis zugänglicher und spielerischer macht.

Wenn Nutzer:innen Wörter, die sie sich merken möchten, in Vocabulary speichern, kategorisiert das On-Device Foundation Modell die Wörter mithilfe von Natural Language Understanding in benutzerdefinierte Themen wie „Verben“, „Anatomie“ oder „Schwierig“, sodass die App übersichtlich bleibt und beim weiteren Einprägen und Wiederholen hilft. In Platzi, einer umfangreichen Bildungsplattform für spanischsprachige Nutzer:innen, können Lernende bald direkt Fragen zu den Inhalten stellen, die sie gerade in einem Video ansehen, und schell eine Antwort erhalten. Durch die Verankerung des On-Device Modells im Kontext der Lektion ist die App in der Lage Fragen, die Nutzer:innen zu einer bestimmten Lektion haben könnten, in Form einer Unterhaltung zu beantworten.

Inspirierende neue Features für Kreativität und Produktivität

Stuff ist entwickelt worden, um die zahlreichen To-dos im Blick zu behalten, die Nutzer:innen im Laufe des Tages in den Sinn kommen und ihnen dabei zu helfen, ihren Alltag zu organisieren und ihre Ziele zu erreichen. Dank des Foundation Models Frameworks erkennt Stuff jetzt beim Tippen automatisch Daten, Tags und Listen. Man kann einfach „Sophia am Freitag anrufen“ schreiben, und Stuff übernimmt die Details sofort in die richtigen Felder. Im Listen Mode können Nutzer:innen ihre Gedanken aussprechen, beispielsweise „Heute Abend Wäsche waschen“ und „Reisevorbereitungen fürs Wochenende treffen“, und Stuff wandelt sie in strukturierte, bearbeitbare Aufgaben um. Im Scan Mode lassen sich sogar handschriftlich notierte Aufgaben, selbst aus längeren Textabschnitten oder Skizzen, erfassen und direkt hinzufügen.

„Das Foundation Models Framework in iOS 26 hat die neuen Arbeitsabläufe in Stuff revolutioniert,“ sagt Austin Blake, der Entwickler von Stuff. „Es läuft vollständig auf dem Gerät, ist leistungsstark, zuverlässig und bemerkenswert effizient.

Dank seiner Einfachheit konnte ich den Listen Mode und den Scan Mode in einem einzigen Release veröffentlichen — etwas, das sonst deutlich länger gedauert hätte.“

Ob für den ersten Vlog oder für Inhalte auf Social Media, die intuitive Benutzeroberfläche von VLLO macht die Videobearbeitung einfach und unterhaltsam. VLLO hebt die Videobearbeitung auf ein neues Level, indem es das Foundation Models Framework und das Vision Framework von Apple nahtlos integriert. VLLO analysiert auf intelligente Weise eine Videovorschau und schlägt automatisch passende Hintergrundmusik und dynamische Sticker vor, die auf jede Szene abgestimmt sind.

„VLLO integriert das Foundation Models Framework reibungslos mit Vision-Technologien und senkt so die Einstiegshürden für neue Creator“, sagt Kyunghyun Lee, CEO von Vimosoft und iOS Entwickler „Durch Verwendung des Foundation Models und des Vision Frameworks von Apple konnten wir schnell und effizient fortschrittliche Empfehlungsfunktionen entwickeln – ganz ohne Implementierung komplexer Algorithmen, allein mit einfachen Prompts.“

Weitere Kreativitäts- und Produktivitäts-Apps haben ebenfalls auf das Foundation Models Frameworks gesetzt, um neue Features in ihren Apps bereitzustellen. Signeasy kann jetzt Zusammenfassungen erstellen, wichtige Punkte hervorheben und bietet eine dialogorientierte Schnittstelle, über die Nutzer:innen Fragen zu spezifischen Dokumenten stellen und schnell Antworten erhalten können. Agenda hat Ask Agenda entwickelt, einen intelligenten Assistenten, den Anwender:innen nutzen können, um Fragen zu ihrer Notizbibliothek zu stellen.

Ask Agenda findet relevante Informationen und gibt verständliche Antworten mit Links zu den relevantesten Notizen.

Außerdem nutzt Detail: AI Video Editor das Foundation Models Framework, um aus einem Entwurf oder einer Gliederung ein sofort einsatzbereites Teleprompter-Skript zu erstellen. Wenn ein Video zur Veröffentlichung bereit ist, können Titel, Beschreibung, Hashtags und Nachrichten automatisch generiert werden. Essayist verwendet neben dem Foundation Models Framework auch das Vision Framework von Apple, um Informationen aus PDFs zu extrahieren und in strukturierte Referenzen und Zitate umzuwandeln. Nutzer:innen können einfach ein PDF per Drag & Drop hinzufügen und erhalten sofort eine Referenz im Zitierstil ihrer Wahl. OmniFocus 4 – eine App, mit der Anwender:innen spontan Aufgaben erstellen und diese mit Projekten, Tags und Daten organisieren können – kann jetzt Projekte und nächste Schritte für Nutzer:innen generieren, beispielsweise Packlisten für bevorstehende Reisen. Die App kann automatisch Vorschläge basierend auf bestehenden Tags ausfüllen und sogar neue Tags für erfasste Inhalte vorschlagen.

Entwickeln mit dem Foundation Models Framework

Das Foundation Models Framework ist eng in Swift integriert, und macht es Entwickler:innen einfach, Anfragen direkt aus ihrem bestehenden Code an das On-Device Modell mit drei Milliarden Parametern zu senden. Das Framework bietet eine geführte Generierung, die sicherstellt, dass die Modelle stets in einem konsistenten Format antworten, auf das sich Entwickler:innen verlassen können. Darüber hinaus können Entwickler:innen dem Modell Tools zur Verfügung stellen, die eine Rückmeldung an die App geben, wenn das Modell zusätzliche Informationen für die Verarbeitung benötigt. So wird gewährleistet, dass dem Modell alle erforderlichen Informationen für eine Antwort zur Verfügung stehen. Das Foundation Models Framework ist mit iOS 26, iPadOS 26 und macOS 26 verfügbar und funktioniert auf jedem Apple Intelligence-kompatiblen Gerät, wenn Apple Intelligence aktiviert ist.

Artikel teilen

Media

-

Text dieses Artikels

-

Medieninhalte zu dieser Pressemeldung

- Apple Intelligence ist als Betaversion mit Unterstützung für folgende Sprachen verfügbar: Englisch, Französisch, Deutsch, Italienisch, Portugiesisch (Brasilien), Spanisch, Chinesisch (Vereinfacht), Japanisch und Koreanisch. Einige Funktionen sind möglicherweise nicht in allen Regionen oder allen Sprachen verfügbar. Informationen zur Verfügbarkeit von Features und Sprachen und zu den Systemanforderungen unter support.apple.com/de-de/121115.